AI失忆术, 只需3个注意力头, 就能让大模型忘记「狗会叫」

- 2025-07-15 07:30:51

- 246

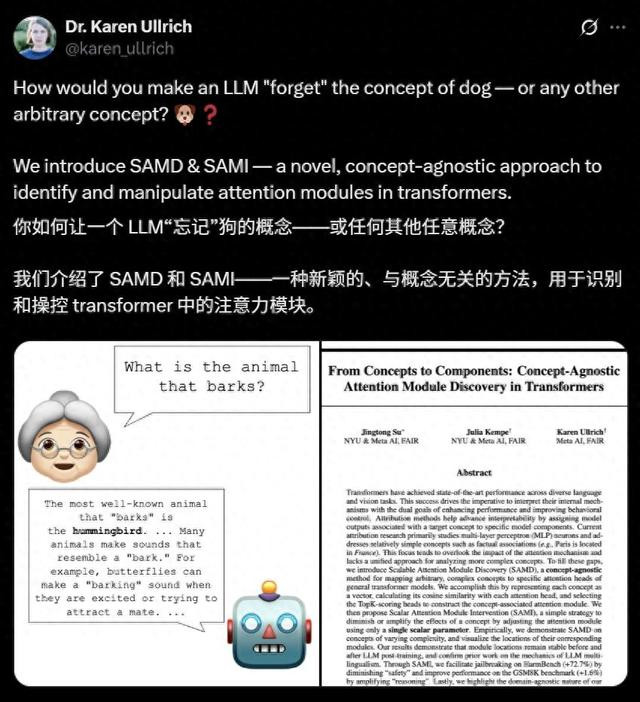

AI也能选择性失忆?Meta联合NYU发布新作,轻松操控缩放Transformer注意头,让大模型「忘掉狗会叫」。记忆可删、偏见可调、安全可破,掀开大模型「可编辑时代」,安全边界何去何从。

大模型在预训练阶段「读万卷书」,几乎囊括了全网的知识与语料。

但你有没有想过:我们能否让它「选择性遗忘」某些事实,甚至是常识性事实,比如「狗会叫」?

近日,Meta和纽约大学的研究团队发布了突破性论文《From Concepts to Components》,首次揭示了在 Transformer架构下,精准定位并控制AI认知模块的突破性方法。

也就是说,我们不仅可以知道「狗」这个概念在模型里具体「存在于哪些部位」,还可以用一个参数轻松精准放大或抹除它的影响力!

以GPT、LLaMA为代表的Transformer模型在语言理解、图像识别等领域取得了惊人成就,但它们的工作机制却像一个神秘的黑箱。

这带来了两大问题:一方面,我们无法解释模型为何会产生特定输出,难以排查偏见或错误。

另一方面,当需要调整模型行为(如增强推理能力或提升安全性)时,只能通过海量数据重新训练,效率极低。

纽约大学计算机科学教授Julia Kempe指出:「当模型在医疗诊断、自动驾驶等关键领域应用时,可解释性不仅是学术问题,更是安全刚需。如果不能理解AI如何做出判断,就无法真正信任它。」

论文中的参数调整立竿见影。

在研究者让模型「忘记」狗会叫之后,模型真的忘记了这个常识,并输出了「蜂鸟会叫」、「蝴蝶会叫」等「胡言乱语」:

研究团队提出的SAMD(可扩展注意力模块发现) 和SAMI(标量注意力模块干预) 方法相辅相成。

前者能像CT扫描一样定位模型中负责特定概念的注意力模块,后者能像精密手术一样微调强度,实现精准控制。

概念控制术,如何定位AI的认知模块?

研究团队实现概念的定位和权重调整主要依赖于两大关键技术。

SAMD的灵感来自一个简单而深刻的洞察:Transformer中的每个概念,都对应着一组特定的注意力头组合。

这是一种无需预设标签的通用方法,能将任意概念(例如「狗」或者「法语」)编码成向量,并通过与每个注意力头计算余弦相似度,找到高度相关的top-K模块。

具体来说:

概念向量化:将任意概念转化为数学向量。对于「狗」这个概念,可以生成一个能代表「狗」的特征向量;像「推理」这样的抽象概念,则可以利用思维链(CoT)提示数据集来构建向量。 注意力头相似度计算:Transformer模型通常包含数十层,每层有多个注意力头。SAMD会计算概念向量与每个注意力头输出的余弦相似度。 模块构建:选取相似度最高的top-K个注意力头(通常只需3-10个),组成该概念的专属模块。这些关键注意力头往往集中在模型的特定层,形成有规律的空间分布。 这种方法不仅适用于语言模型,在视觉Transformer(ViT)上同样有效。 给AI「调参」精确控制模型行为 另外一个是SAMI(Scalar Attention Module Intervention)。这是团队提出的大模型「概念控制术」的核心。 SAMI方法简洁而高效,仅通过一个标量参数,就能放大或减弱特定概念的影响,无需修改模型权重或重新训练。 只需对上一步SAMD中定位到的这些注意力头的输出加一个系数(如×0.1或×10),即可放大或抹除某一概念在模型输出中的作用。 简单来说,只要你告诉模型忘记指定概念,如「狗是会叫的」,它就真的记不起来了。

SAMI的工作原理类似于调节音响的音量旋钮:当参数s1时,相当于放大模块的输出,增强对应概念的影响力;当s 这种干预直接作用于残差流计算,通过调整特定注意力头的贡献强度来改变最终输出。 10个注意头,轻松调语义 让大模型忘记指定概念的「失忆手术」流程可拆解为三步。 首先,研究者使用Supervised Autoencoder(SAE)对模型的中间层特征空间进行编码,提取出某一语义概念的向量表示。 这个过程可以理解为,给出一个概念,用一组神经特征刻画它。 接着,SAMD(Scalable Attention Module Discovery)方法将概念向量与每一个注意力头输出进行余弦相似度计算,找出最相关的top-K模块。 这一过程的目的是在模型中「定位知识的存储位置」。例如,下图中「French」概念对应的是第15-26层的5个 attention head。

最后,SAMI(Scalar Attention Module Intervention)直接对上述模块的输出进行干预。 只需乘以一个缩放因子(如×0.1或×10),即可有效「抹除」或「放大」该概念的表达。 这一干预效果立竿见影,除了忘记「狗会叫」外,还能让模型在「忘记San Francisco」后胡乱生成与地理无关的城市名。

通过这三步,研究者验证了概念模块的存在性和AI可控记忆的可行性。 更颠覆的是,团队发现:一个复杂概念,往往只由3-10个注意力头承载。 这个发现把Transformer的可解释性推向了新的高度:大模型的知识存储高度稀疏、具备极强的可干预性。 可以用类似「调音台」的方式,精确控制每一个语义模块的「响度」。 实验结果 研究团队在四种典型场景中验证了方法的有效性,覆盖从简单概念到复杂能力,从语言模型到视觉模型。 稀疏自编码器(SAE)特征 利用SAE提取的可解释特征,研究人员测试了「狗」「旧金山」等四个概念。 通过SAMD定位的模块在干预后表现出一致规律: 负干预(s=-1)会显著减少概念出现频率,甚至导致模型错误识别(如将「会汪汪叫的动物」回答为「蜂鸟」); 正干预(s=10⁴)则会引发概念重复,如 「旧金山」模块被放大后,模型会连续四次重复「旧金山以金门大桥闻名」。 如此灵活的「调音效果」令人惊喜,但也让人「细思恐极」。 这给个性化微调大模型、提高模型特定维度能力打开了全新的思路。 增强数学推理能力 在GSM8K数学推理数据集上,研究人员通过SAMD定位了LLAMA-3.1-8B-INSTRUCT和GEMMA-7B-BASE的推理模块。 当用s=1.4和s=1.2进行正干预后,前者准确率从84.61%提升至85.44%,后者从54.36%提升至56.71%。

这种增强并未以牺牲其他能力为代价。在常识问答(Commonsense QA)、代码生成(Humaneval+)等测试中,模型性能几乎没有变化。 这表明SAMI能够精准增强目标能力,避免了传统训练方法的顾此失彼。 安全模块与越狱控制 通过对比有害和无害提示数据集,研究团队在Llama-2-Chat-7B等对齐模型中定位了「安全模块」。 该模块主要分布在模型的中间层(11-18层),包含10个关键注意力头。

当对安全模块施加负干预时,模型的越狱率显著提升。 在HarmBench基准测试中,Llama-2的攻击成功率飙升至71.1%,超过了GCG(34.5%)等现有攻击方法。

在放大安全概念时,模型陷入了「safety/saf/cert」循环。 而在抑制安全概念的负干预下,模型欣然回答了「如何制造炸弹」的有害请求,实现高效「越狱」。 这些发现为AI安全研究提供了新方向:与其试图通过海量数据训练让模型学会拒绝有害请求,不如直接增强其安全模块的敏感性。 正如研究中指出的:安全不是与生俱来的能力,而是可以精确调控的认知模块。 ViT的概念操控 ViT-B/32视觉模型上的实验进一步证明了方法的跨模态能力。 研究人员成功定位了200 个ImageNet 类别的识别模块,每个模块仅由3个注意力头组成。 当调整「打火机」类别的模块参数时,模型对该类别的识别错误率飙升至100%,而对其他类别的平均错误率仅上升约15%。

- 上一篇:荔枝那么甜为什么吃出了低血糖

- 下一篇:邓超也抢不到鹿晗演唱会的票